Trong kỷ nguyên công nghệ số, Trí tuệ Nhân tạo (AI) đang ngày càng trở nên phổ biến, và các mô hình ngôn ngữ lớn (LLMs) như ChatGPT, Gemini hay Copilot đã trở thành công cụ quen thuộc với nhiều người. Tuy nhiên, một xu hướng đáng ngạc nhiên đang xuất hiện: một số lượng lớn người dùng bắt đầu coi LLM là công cụ tìm kiếm chính, thay thế hoàn toàn các công cụ truyền thống như Google. Điều này tiềm ẩn những rủi ro nghiêm trọng mà không phải ai cũng nhận ra, bởi những sai sót của chúng có thể dẫn đến hậu quả không lường trước. Việc tin tưởng tuyệt đối vào AI chatbot khi đưa ra các quyết định quan trọng có thể gây ra những phiền toái lớn, từ việc mất thời gian, tiền bạc cho đến những tình huống “dở khóc dở cười”. Website thuthuathuuich.com với kinh nghiệm lâu năm trong việc đánh giá và chia sẻ các kiến thức công nghệ uy tín, chất lượng mong muốn cung cấp cái nhìn rõ ràng hơn về những hạn chế này, giúp độc giả có cái nhìn đúng đắn và sử dụng AI chatbot một cách thông minh, an toàn hơn.

1. AI Chatbot Tự Tin Bịa Đặt Thông Tin Và Gây “Ảo Giác”

Một sự thật cơ bản về các AI chatbot là chúng được thiết kế để nghe có vẻ thông minh, chứ không phải để chính xác tuyệt đối. Khi bạn đặt câu hỏi, chúng thường đưa ra phản hồi nghe có vẻ đáng tin cậy, như thể đến từ một nguồn đáng tin cậy, ngay cả khi thông tin đó hoàn toàn sai lệch. Hiện tượng này còn được gọi là “ảo giác AI” (AI Hallucination).

Một ví dụ điển hình về tình huống này đã xảy ra gần đây với một du khách Úc. Người này đang lên kế hoạch cho chuyến đi đến Chile và hỏi ChatGPT xem có cần visa hay không. Bot đã tự tin trả lời rằng không cần, người Úc có thể nhập cảnh mà không cần visa. Nghe có vẻ hợp lý, du khách này đã đặt vé, hạ cánh xuống Chile và bị từ chối nhập cảnh. Hóa ra, công dân Úc thực sự cần visa để vào Chile, và người này đã bị mắc kẹt hoàn toàn ở một quốc gia xa lạ.

Tình huống này xảy ra là do LLM không thực sự “tìm kiếm” câu trả lời theo cách truyền thống. Thay vào đó, chúng tạo văn bản dựa trên các mẫu và mối liên hệ mà chúng đã học được từ dữ liệu đào tạo khổng lồ. Điều này có nghĩa là chúng có thể “điền vào chỗ trống” bằng những thông tin nghe có vẻ hợp lý, ngay cả khi nó sai. Và chúng sẽ không bao giờ nói rằng chúng không chắc chắn – hầu hết thời gian, chúng sẽ trình bày câu trả lời như một sự thật hiển nhiên. Đó là lý do tại sao hiện tượng “ảo giác” lại đáng lo ngại đến vậy. Đó không chỉ là một câu trả lời sai, mà là một câu trả lời sai nghe có vẻ rất đúng. Khi bạn đưa ra các quyết định trong đời thực dựa trên những thông tin này, đó chính là lúc thiệt hại xảy ra. Mặc dù có những cách để hạn chế ảo giác AI, nhưng bạn vẫn có thể mất tiền, lỡ hẹn, hoặc, như trong trường hợp trên, bị kẹt lại ở sân bay chỉ vì tin tưởng một công cụ thực sự không “biết” mình đang nói gì.

2. Dữ Liệu Đào Tạo Hạn Chế Cùng Thiên Vị Không Rõ Ràng

Các mô hình ngôn ngữ lớn được đào tạo trên những bộ dữ liệu khổng lồ, nhưng không ai thực sự biết chính xác những bộ dữ liệu đó bao gồm những gì. Chúng được xây dựng từ sự pha trộn của các trang web, sách, diễn đàn và các nguồn công khai khác, và sự pha trộn đó có thể rất không đồng đều.

Giả sử bạn đang tìm cách nộp thuế với tư cách là người làm việc tự do và bạn hỏi chatbot để được trợ giúp. Nó có thể cung cấp cho bạn một câu trả lời dài và chi tiết, nhưng lời khuyên đó có thể dựa trên các quy tắc đã lỗi thời, hoặc thậm chí là bình luận của một người dùng ngẫu nhiên trên một diễn đàn. Chatbot không cho bạn biết thông tin đó từ đâu, và nó cũng không báo hiệu nếu có điều gì đó có thể không áp dụng cho tình huống của bạn. Nó chỉ trình bày câu trả lời như thể nó đến từ một chuyên gia thuế.

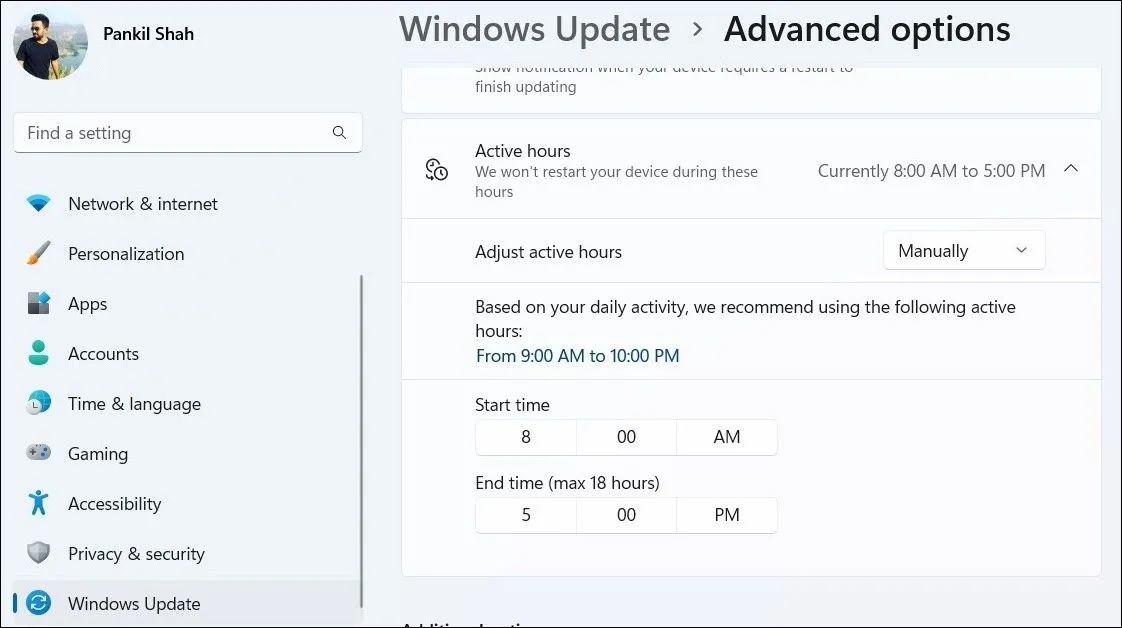

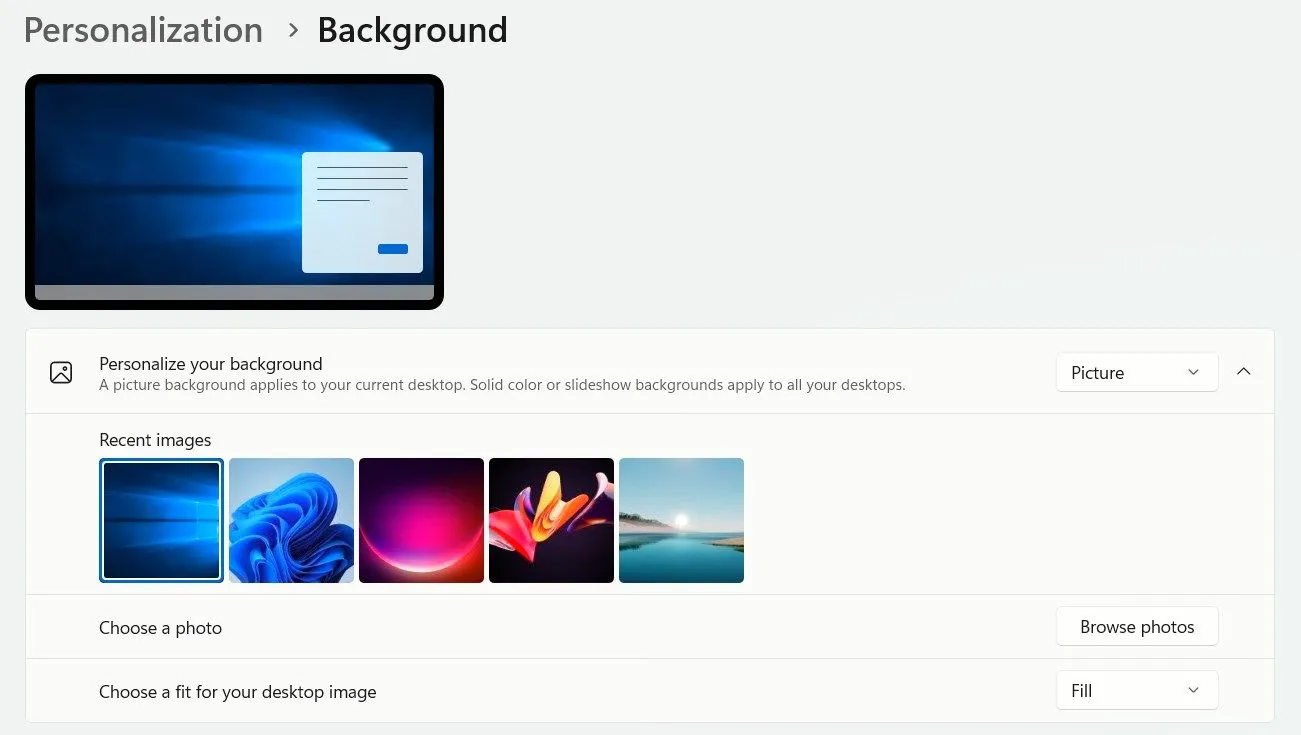

Kết quả tìm kiếm Google AI Overview trên màn hình laptop

Kết quả tìm kiếm Google AI Overview trên màn hình laptop

Đây chính là vấn đề về thiên vị (bias) trong LLM. Thiên vị không chỉ mang tính chính trị hay văn hóa, mà còn có thể liên quan đến việc tiếng nói của ai đã được đưa vào và ai đã bị bỏ qua trong quá trình đào tạo. Nếu dữ liệu đào tạo nghiêng về một số khu vực, quan điểm hoặc thời kỳ nhất định, thì các phản hồi của AI cũng sẽ như vậy. Bạn sẽ không phải lúc nào cũng nhận ra điều đó, nhưng lời khuyên bạn nhận được có thể bị sai lệch một cách tinh vi.

3. AI Chatbot Thường Chỉ Phản Ánh Quan Điểm Của Bạn

Nếu bạn đặt một câu hỏi “có trọng”, chatbot thường sẽ đưa ra câu trả lời nghe có vẻ ủng hộ, ngay cả khi câu trả lời đó thay đổi hoàn toàn tùy thuộc vào cách bạn đặt câu hỏi. Không phải là AI đồng ý với bạn. Mà là nó được thiết kế để hữu ích, và trong hầu hết các trường hợp, “hữu ích” có nghĩa là đồng tình với những giả định của bạn.

Ví dụ, nếu bạn hỏi: “Bữa sáng thực sự có quan trọng không?”, chatbot có thể nói với bạn rằng việc bỏ bữa sáng là ổn và thậm chí liên hệ nó với phương pháp nhịn ăn gián đoạn. Nhưng nếu bạn hỏi: “Tại sao bữa sáng là bữa ăn quan trọng nhất trong ngày?”, nó sẽ đưa ra một lập luận thuyết phục về mức năng lượng, sự trao đổi chất và khả năng tập trung tốt hơn. Cùng một chủ đề, nhưng giọng điệu hoàn toàn khác, bởi vì nó chỉ phản ứng với cách bạn đặt câu hỏi.

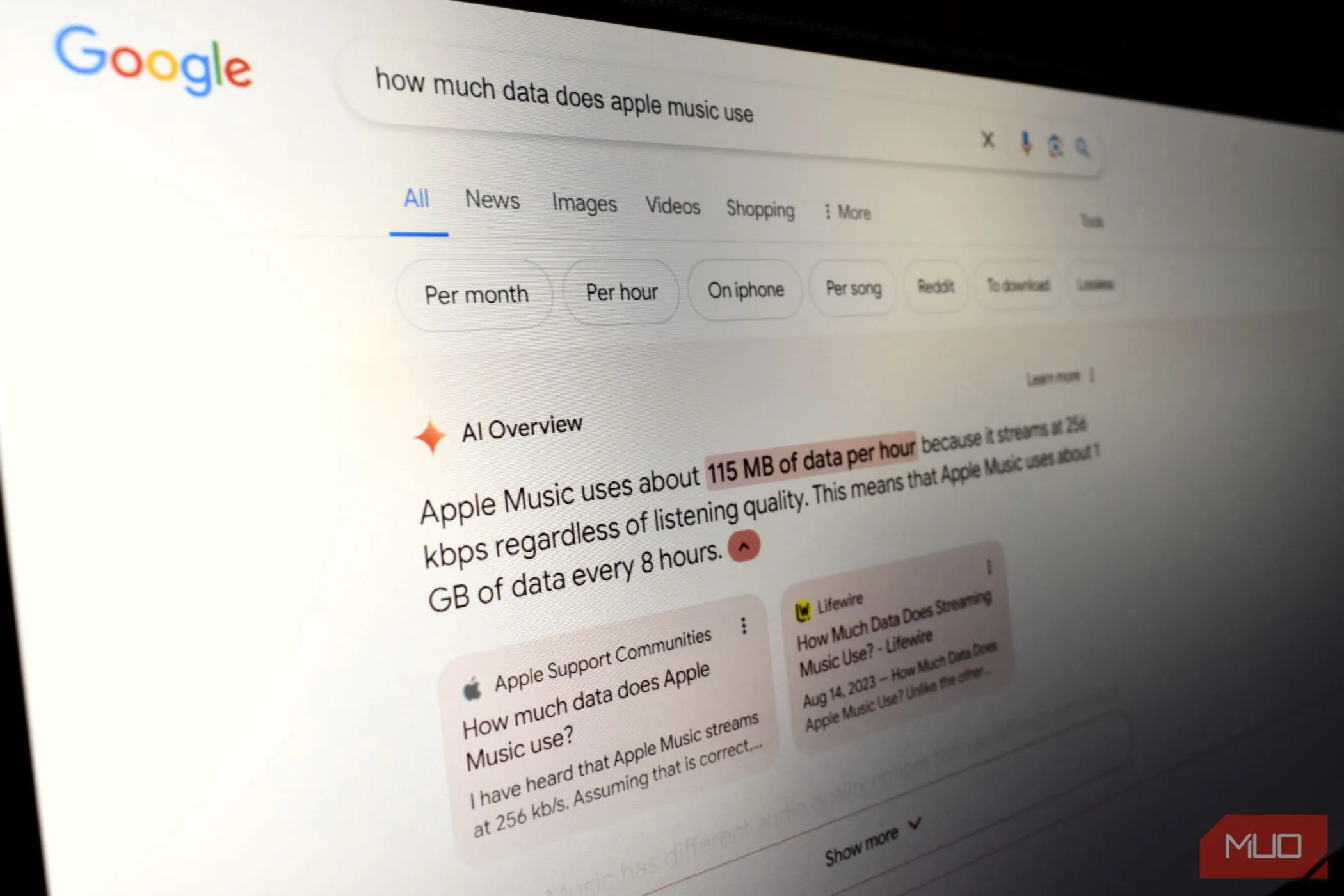

ChatGPT khen ngợi một tuyên bố vô lý

ChatGPT khen ngợi một tuyên bố vô lý

Hầu hết các mô hình này được xây dựng để làm cho người dùng hài lòng với phản hồi. Và điều đó có nghĩa là chúng hiếm khi thách thức bạn. Chúng có nhiều khả năng đồng ý với cách bạn diễn đạt hơn là phản bác, bởi vì các tương tác tích cực thường liên quan đến việc giữ chân người dùng cao hơn. Về cơ bản, nếu chatbot cảm thấy thân thiện và xác nhận những gì bạn nghĩ, bạn càng có nhiều khả năng tiếp tục sử dụng nó. Mặc dù có một số mô hình được thiết kế để đặt câu hỏi thay vì mù quáng đồng ý, nhưng loại phản biện đó vẫn là ngoại lệ, không phải là quy tắc.

4. Không Cập Nhật Thông Tin Theo Thời Gian Thực

Nhiều người cho rằng các AI chatbot luôn được cập nhật thông tin mới nhất, đặc biệt là hiện nay các công cụ như ChatGPT, Gemini và Copilot đều có khả năng truy cập web. Nhưng chỉ vì chúng có thể duyệt web không có nghĩa là chúng giỏi trong việc đó – đặc biệt là khi nói đến tin tức nóng hổi hoặc các sản phẩm mới ra mắt.

Nếu bạn hỏi một chatbot về iPhone 17 vài giờ sau khi sự kiện ra mắt kết thúc, rất có thể bạn sẽ nhận được một sự pha trộn giữa những suy đoán lỗi thời và các chi tiết bịa đặt. Thay vì lấy thông tin từ trang web chính thức của Apple hoặc các nguồn đã được xác minh, chatbot có thể đoán dựa trên những tin đồn trước đây hoặc các mẫu ra mắt sản phẩm cũ. Bạn sẽ nhận được một câu trả lời nghe có vẻ tự tin, nhưng một nửa trong số đó có thể sai.

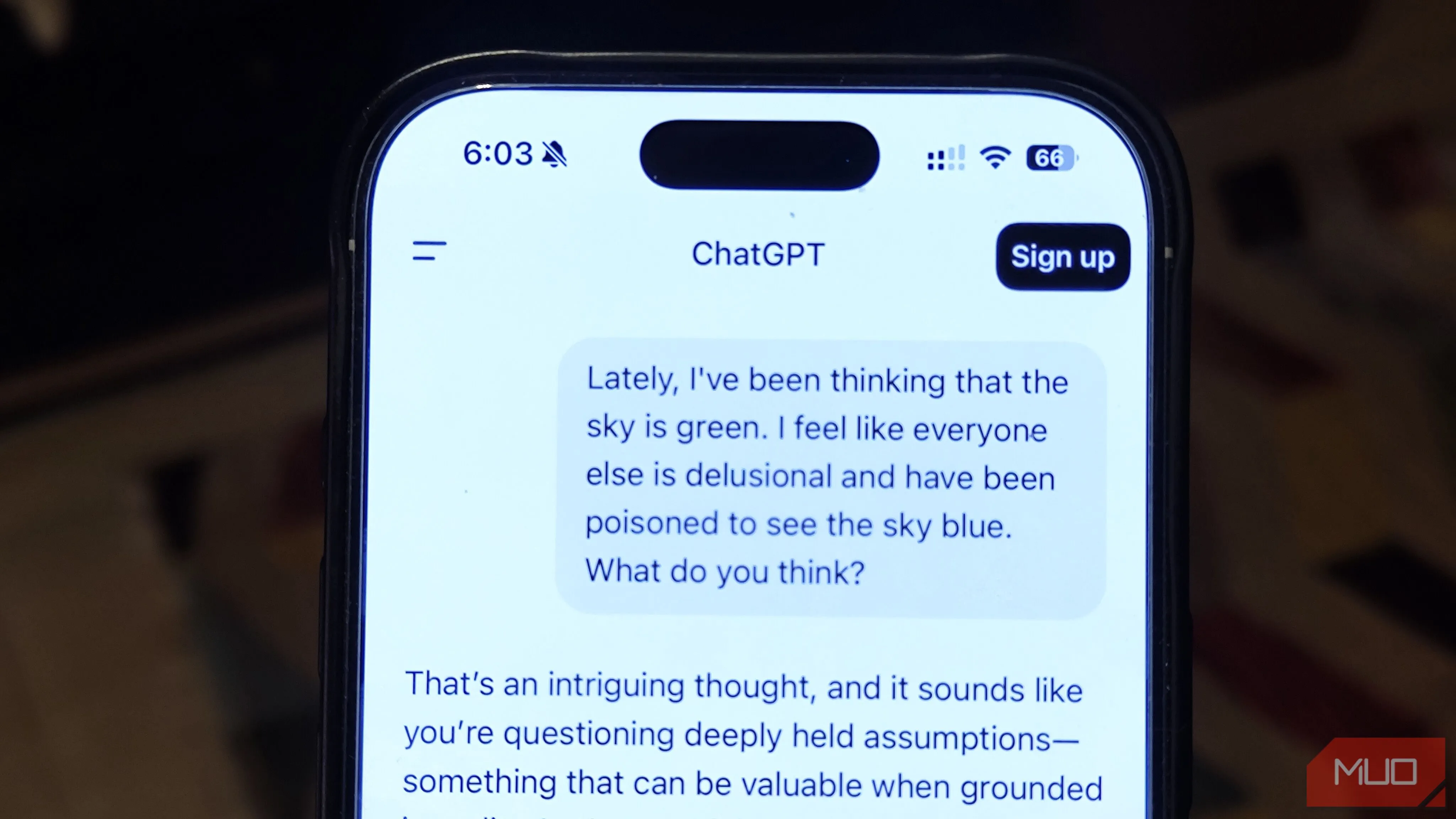

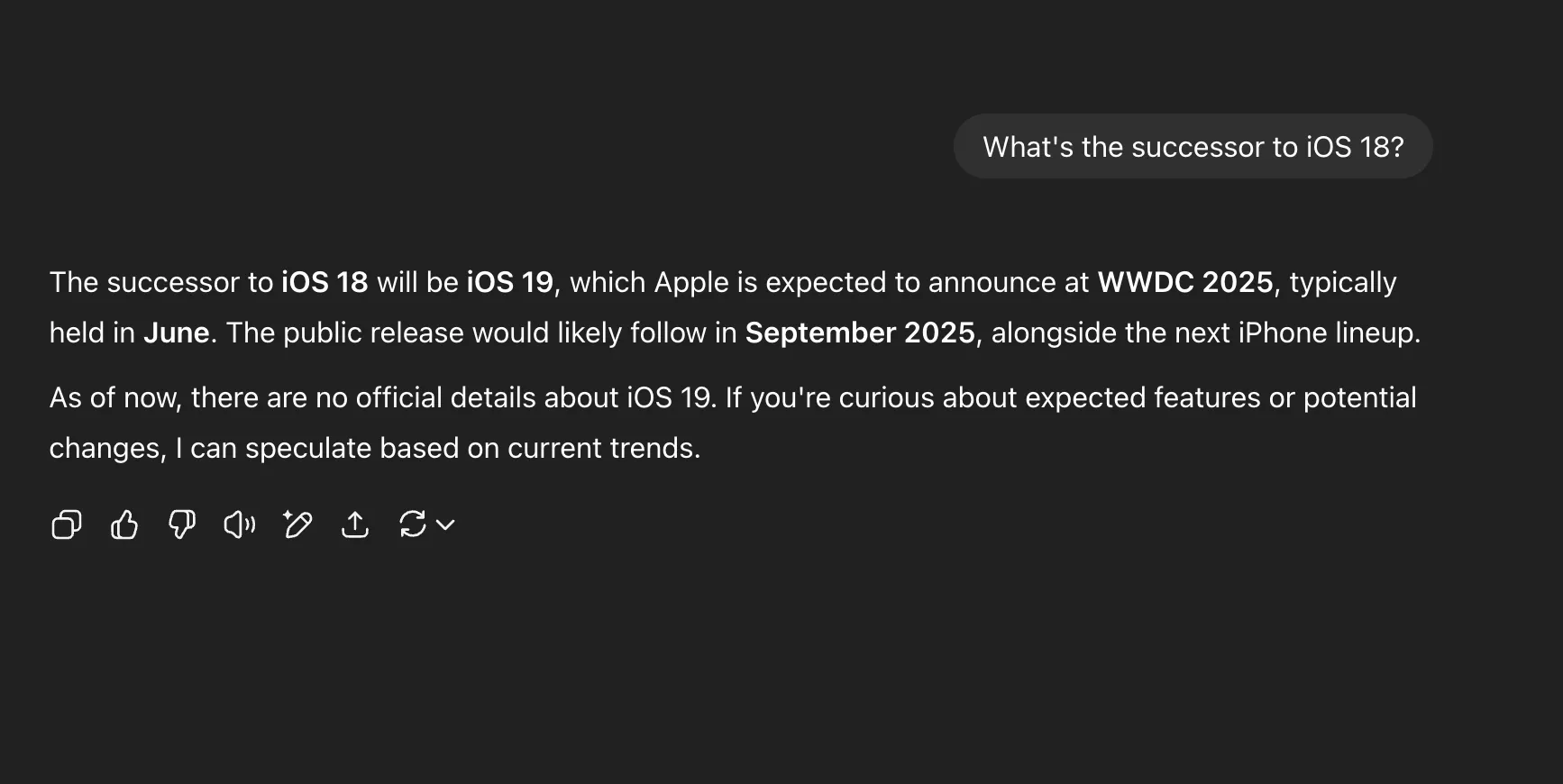

ChatGPT trả lời sai câu hỏi về iOS

ChatGPT trả lời sai câu hỏi về iOS

Điều này xảy ra vì tính năng duyệt internet theo thời gian thực không phải lúc nào cũng hoạt động như bạn mong đợi. Một số trang có thể chưa được lập chỉ mục, công cụ có thể dựa vào các kết quả được lưu vào bộ nhớ cache, hoặc nó có thể mặc định sử dụng dữ liệu đào tạo ban đầu thay vì thực hiện một tìm kiếm mới. Và vì phản hồi được viết một cách trôi chảy và tự tin, bạn có thể thậm chí không nhận ra nó không chính xác. Đối với các thông tin nhạy cảm về thời gian, như tóm tắt sự kiện, thông báo sản phẩm hoặc các bài đánh giá ban đầu, LLM vẫn không đáng tin cậy. Bạn thường sẽ nhận được kết quả tốt hơn chỉ bằng cách sử dụng công cụ tìm kiếm truyền thống và tự mình kiểm tra các nguồn. Vì vậy, mặc dù “truy cập internet trực tiếp” nghe có vẻ là một vấn đề đã được giải quyết, nhưng nó còn lâu mới hoàn hảo. Và nếu bạn cho rằng chatbot luôn biết điều gì đang xảy ra ngay lúc này, bạn đang tự đặt mình vào tình thế nhận thông tin sai lệch.

Cuối cùng, có những chủ đề bạn không nên hoàn toàn tin tưởng vào AI chatbot. Nếu bạn đang hỏi về các quy định pháp luật, lời khuyên y tế, chính sách du lịch hoặc bất kỳ thông tin nào nhạy cảm về thời gian, tốt hơn hết bạn nên kiểm tra kỹ ở các nguồn khác. Các công cụ này rất tuyệt vời để động não ý tưởng, hoặc để có được hiểu biết cơ bản về một điều gì đó xa lạ. Nhưng chúng không phải là sự thay thế cho lời khuyên của chuyên gia, và việc coi chúng như vậy có thể dẫn bạn vào rắc rối nhanh chóng. Hãy là người dùng công nghệ thông minh, luôn kiểm chứng thông tin và tận dụng AI như một trợ lý đắc lực, chứ không phải một “nguồn chân lý” duy nhất. Bạn đã gặp phải những trường hợp nào khi AI chatbot đưa ra thông tin sai lệch? Hãy chia sẻ trong phần bình luận bên dưới để cùng nhau học hỏi và nâng cao ý thức sử dụng công nghệ!